Η Meta μόλις ανακοίνωσε το δικό της μοντέλο τεχνητής νοημοσύνης με επίκεντρο τα μέσα ενημέρωσης, το οποίο ονομάζεται Movie Gen και μπορεί να χρησιμοποιηθεί για τη δημιουργία ρεαλιστικών βίντεο και ηχητικών κλιπ.

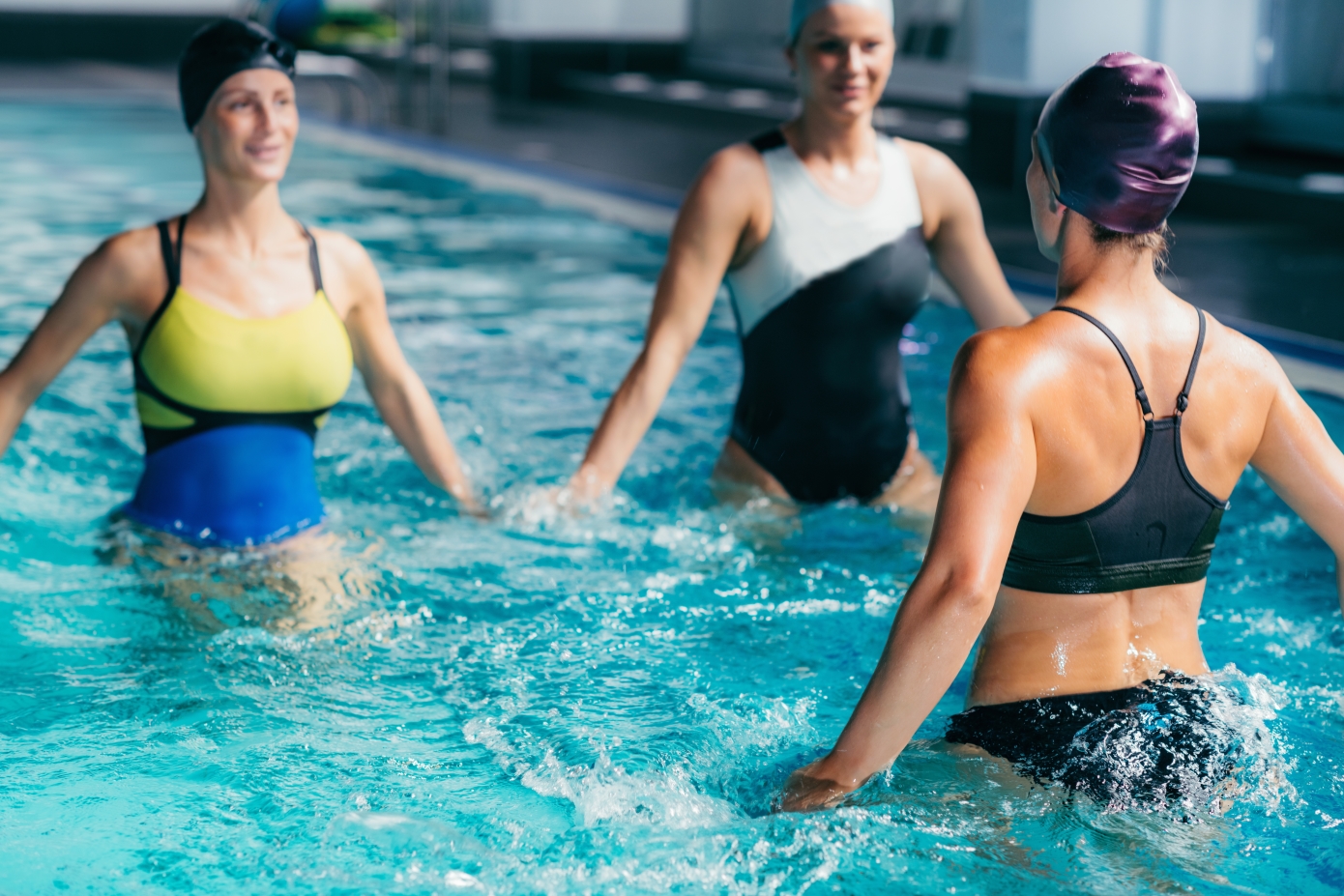

Η εταιρεία μοιράστηκε πολλαπλά κλιπ των 10 δευτερολέπτων που δημιουργήθηκαν με το Movie Gen, συμπεριλαμβανομένου ενός μωρού ιπποπόταμου που μοιάζει με τον Moo Deng και κολυμπάει, για να επιδείξει τις δυνατότητές του. Αν και το εργαλείο δεν είναι ακόμη διαθέσιμο προς χρήση, η ανακοίνωση του Movie Gen έρχεται λίγο μετά την εκδήλωση Meta Connect, στην οποία παρουσιάστηκε νέο και ανανεωμένο υλικό και η τελευταία έκδοση του μεγάλου γλωσσικού μοντέλου της, το Llama 3.2.

Ξεπερνώντας τη δημιουργία απλών κλιπ από κείμενο σε βίντεο, το μοντέλο Movie Gen μπορεί να κάνει στοχευμένες επεξεργασίες σε ένα υπάρχον κλιπ, όπως η προσθήκη ενός αντικειμένου στα χέρια κάποιου ή η αλλαγή της εμφάνισης μιας επιφάνειας. Σε ένα από τα παραδείγματα βίντεο από το Meta, μια γυναίκα που φορούσε ακουστικά VR μεταμορφώθηκε ώστε να μοιάζει σαν να φοράει steampunk κιάλια.

Ακόμη, ηχητικά αποσπάσματα μπορούν να δημιουργηθούν παράλληλα με τα βίντεο με το Movie Gen.

Η Meta μοιράστηκε κάποιες περαιτέρω λεπτομέρειες σχετικά με το Movie Gen, και σύμφωνα με το wired.com, το Movie Gen Video αποτελείται από 30 δισεκατομμύρια παραμέτρους, ενώ το Movie Gen Audio αποτελείται από 13 δισεκατομμύρια παραμέτρους (ο αριθμός των παραμέτρων ενός μοντέλου αντιστοιχεί περίπου στο πόσο ικανό είναι -αντίθετα, η μεγαλύτερη παραλλαγή του Llama 3.1 έχει 405 δισεκατομμύρια παραμέτρους).

Το Movie Gen μπορεί να παράγει βίντεο υψηλής ευκρίνειας διάρκειας έως και 16 δευτερολέπτων και η Meta ισχυρίζεται ότι ξεπερνά τα ανταγωνιστικά μοντέλα σε συνολική ποιότητα βίντεο.

Λαμβάνοντας υπόψη την κληρονομιά της Meta ως εταιρείας μέσων κοινωνικής δικτύωσης, είναι πιθανό ότι τα εργαλεία που υποστηρίζονται από την Movie Gen θα αρχίσουν να εμφανίζονται, τελικά, μέσα στο Facebook, το Instagram και το WhatsApp.